NOS I.A ONT UN GROS Q.I !

10 années de R&D Universitaire avec l’IMAG et l’INRIA. Direction de thèse en cours

Simulation du comportement humain à base d’algorithmes prédictifs et prescriptifs

Jusqu’à 1200 variables d’enrichissement (insee, iris, dila….)

+ 70 % de bonnes classifications après apprentissage

Un processus unique de modélisation du comportement…

« algorithmes cognitifs à évolution rapide »

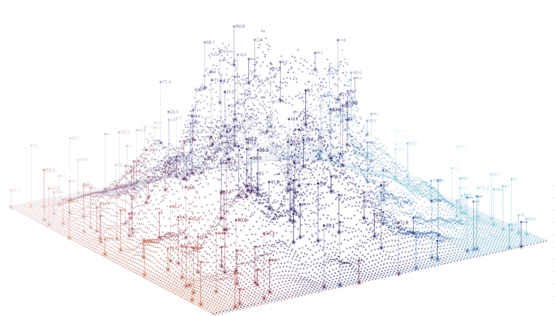

Nos algorithmes comportementaux se basent sur le principe des forêts aléatoires auto génératrices auxquelles sont intégrés des concepts proches du « vivant » permettant d’obtenir des probabilités toujours plus robustes et un scoring client de qualité.

Une connaissance affinée par l’enrichissement massif

L’enrichissement consiste à aller chercher, des données issues de sources externes (bases big data, open data, INSEE, INPI, Infogreffe, bases privées, réseaux sociaux, zones Iris…) jusqu’à 1200 variables ! Mises en corrélation avec les données 1st party, elles révèlent des tendances fondamentales dans les résultats obtenus.

Des milliards de combinaisons testées en permanence pour optimiser les résultats en temps réel

Les forêts aléatoires évolutives vont venir croiser l’ensemble des données afin d’identifier les combinaisons à plus fortes valeurs. Grâce à un apprentissage continu le système analyse de façon répétée les données et génère avec fiabilité la meilleure réponse à la question initiale.

UNE BASE DE DONNÉES ÉVOLUTIVE

Les données sur lesquelles nous travaillons sont pour la plupart des données concernant des « humains » et l’une des caractéristiques dont nous devons tenir compte est la diversité des comportements.

En effet, les femmes et les hommes changent, évoluent, réagissent et s’adaptent en fonction de leurs particularités. Les données stockées qui les caractérisent doivent donc en faire autant. Ainsi, il n’est plus question de prendre en compte une base de données figée, mais une base de données évolutive selon divers facteurs : environnement, influences, tendances, météo…

Pour exploiter de telles données les algorithmes ont été redéveloppés dans un langage probabiliste « le probabilistic programming » permettant ainsi de créer des modèles qui prennent des décisions à partir d’observations en temps réel.

Des milliards de combinaisons sont testées en permanence pour fournir des résultats toujours meilleurs en temps réel

Les forêts aléatoires évolutives vont venir croiser l’ensemble des données entre elles, quel que soit leur type : quantitatives, qualitatives, ordinales ou encore supervisées, non supervisées, afin d’identifier les combinaisons à plus fortes valeurs et les stocker dans un modèle prédictif évolutif.

Grâce à un apprentissage continu, dont la durée peut varier entre 3 et 4 mois, le système analyse de façon répétée les données et génère avec fiabilité la meilleure réponse à la question initiale.

Chaque question posée au système génère un modèle spécifique. Notre solution créée ainsi autant de modélisation qu’il y a de questions.

La pertinence des concepts « Vrais positifs » et « Vrais négatifs » en data intelligence

La qualité d’un modèle de classification en data science se mesure par ses probabilités de bonne classification. Cependant un « bon » taux de bonne classification général peut parfois cacher des résultats insatisfaisants.

Exemple : « si la base de données à partir de laquelle le modèle « acheteur / non acheteur » est créé contient moins de 20% d’acheteurs, il suffit que le modèle classe tous les individus dans le groupe non acheteurs pour avoir un taux de bonne classification général de 80 % ».

En conséquence, les taux de bonne classification de nos modèles s’expriment en termes de taux de « vrais positifs » (individus bien classés répondant positivement à la question) et de taux de « vrais négatifs » (individus bien classés répondant négativement à la question). Ce n’est qu’une fois ces deux indicateurs validés en termes de performance que le modèle est confirmé.

Une connaissance client affinée grâce à un enrichissement massif et intelligent des data !

Pour obtenir des modèles de marketing prédictifs fiables, nos experts en data science ont fait le choix d’inclure une phase d’enrichissement massif aux process de machine learning. L’enrichissement consiste à aller chercher, sans limitation et sans aucun préjugé, des données complémentaires issues de sources externes à l’entreprise : jusqu’à 1200 variables au total ! Une fois mises en corrélation avec l’ensemble des données 1st party communiquées par les entreprises-utilisatrices, elles peuvent alors révéler des tendances fondamentales dans les résultats obtenus. La pertinence des modèles de data science dépendant fortement des données (ou facteurs) qui les nourrissent, cette opération est cruciale et permet aux algorithmes d’exprimer toute leur puissance. La construction d’un modèle prédictif a pour but d’associer chaque individu à sa cible en fonction des divers facteurs présents dans la nouvelle base de données enrichie.

L’étape de création de ces différents facteurs par un processus d’enrichissement est donc stratégique. La mégabase est connectée à de multiples sources, bases big data, open data, INSEE, INPI, Infogreffe, bases privées, réseaux sociaux, zones Iris… À partir de ces sources externes et de ses propres mini-modèles probabilistes, on crée, pour chaque modélisation, ses propres valeurs pertinentes. Nos modèles fonctionnent ainsi sur tous types de bases de données, externes à l’entreprise et non qualifiées.